聚合数据打造的最新API管理工具JuAPI刚刚上线啦!作为系统开发者,我们怀着激动的心情做了一个性能对比测试,检验一下我们的产品有没有做到承诺的更简单,更自由,特别是更快。

测试是在阿里云上的三台2CPU+4G内存的计算型ECS虚拟机进行的(实例类型:ecs.c7.large),运行Ubuntu20.04系统,其中一台作为Nginx流量挡板,一台运行ab,一台运行API网关。计划测试的API网关包括:

hyperapi

Kong

goku

APISIX

测试的只是一个最简单的请求转发场景,访问网关上游的nginx上的一个静态页面,所有网关都配置为apikey的认证方式,并启用各自的RateLimit插件。

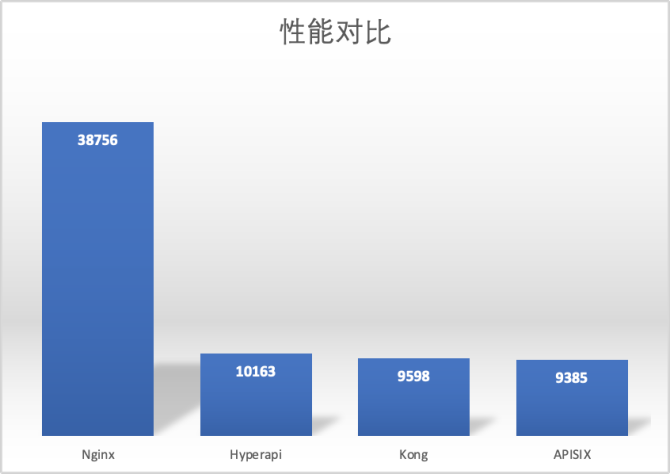

废话少说先上个结果吧:

测试中各个网关的具体配置和运行的测试命令参见项目文档的Benchmark部分。

Baseline

首先使用ab测试了一下nginx返回一个静态页面的性能作为测试基准,在100并发50万次请求下,Nginx服务器的CPU在90%以上,得到的数字是QPS:38756.59

hyperapi

hyperapi是JuAPI的网关在github上的名字,是一个开源的,基于rust语言,tokio异步框架和hyper库开发的一个API网关。

在这个测试中通过手写的静态配置文件来启动网关服务,在200并发50万次请求的测试运行中,hyperapi进程CPU占用率接近100%,后端nginx进程CPU使用率大约20%,最后的QPS为10164,没有请求出错,99%请求延迟<26ms。

Kong

Kong是一个挺知名的开源API网关产品了,基于nginx和lua开发,产品分为企业版和社区版,官方还提供了各种系统包管理工具的支持,这里就是使用ubuntu的apt-get安装了Kong。

Kong的网关配置支持RESTful接口和配置文件的方式,这里为了简化配置,没有安装数据库和管理系统,也是通过手写配置文件来启动的Kong网关。

在200并发50万次请求的测试运行中,Kong的进程CPU占用率接近100%,后端nginx进程CPU使用率大约20%,最后的QPS为9598,没有请求出错,99%请求延迟<68ms。

Kong作为一个老牌开源网关项目,文档质量在对比的几个产品中是最好的,是我们要学习的榜样。

Goku

Goku是eolinker的API网关软件,使用Go语言开发,产品分为社区版和企业版。但这里想要测试的Goku社区版的文档严重缺失,尽管通过docker顺利安装了控制台和网关节点,但在使用中卡在了Strategy鉴权设置的Authentication-Type上,未能完成测试,可能eolinker不太希望用户使用社区版吧。参考Goku网站上对比Kong的测试结果,估计和Kong是同等级的性能水平。

APISIX

作为新晋成为Apache顶级项目的APISIX,其官网上的测试数据让我十分惊叹,单核就能支撑14000+的QPS,同样是基于Nginx和Lua的API网关产品,Kong在同样的测试环境下在不启用插件的情况下性能水平和APISIX十分接近,但在启用了limit rate + prometheus两个插件后,性能骤降至2500QPS左右,或许是请求数据需要在nginx和lua虚拟机之间传递的代价比较大吧。

这里是按照APISIX手册中的指引,使用docker安装了APISIX的网关和Dashboard,在Dashboard中配置了一个服务,开启了apikey认证和limit-req插件,在同样的硬件条件下,并没有表现出对比Kong的巨大优势:在200并发50万次请求的测试运行中,APISIX的进程CPU占用率接近100%,后端nginx进程CPU使用率大约20%,最后的QPS为9385,没有请求出错,99%请求延迟<46ms。

总结

凭借Rust语言的高性能,和tokio框架优秀的异步计算实现,hyperapi在没有特别的性能调优的情况下性能表现已经可以跻身API网关产品的第一梯队啦。当然也可能是因为项目比较年轻,功能过于精简,在后面的产品功能迭代中还持续关注对性能的影响。

P.S. 测试使用的是阿里云ECS的抢占式实例,启用外网IP按流量付费,半天的测试下来总成本2块钱 😃